Spark教程

ApacheSpark是用于数据处理的最大开源项目之一。Spark是一款用于大数据和机器学习的快速通用统一分析引擎。它支持JAVA、SCALA、PYTHON、SQL和R等语言的高级API。它于2009年在加州大学伯克利分校实验室(现在称为AMPLab)开发。由于spark是用于数据处理的引擎,因此它可以构建在Apache Hadoop、Apache Mesos、Kubernetes的基础上,也可以构建在AWS、Azure或GCP等云上,作为数据存储。

ApacheSpark有自己的库堆栈,如spark SQL、DataFrames、机器学习的spark MLlib、GraphX图形计算、流媒体。该库可以在同一个应用程序中内部组合。

为什么我们需要学习Spark

在当今时代,数据是新的石油,但数据以不同的形式存在,如结构化、半结构化和非结构化。Apache Spark在批处理和流式数据方面实现了高性能。Netflix、亚马逊、雅虎、facebook等大型互联网公司已经开始使用spark进行部署,并使用大约8000个节点的集群来存储数PB的数据。随着技术的日新月异,跟上同样的Apache spark是必须的,下面是一些学习的理由:

- Spark的内存速度是MapReduce的100倍,它可以轻松地与Hadoop生态系统集成,因此Spark在大公司和小公司中的使用正在增加。由于它是开源的,大多数组织已经实现了spark</李>

;

- 由于数据来自移动应用程序、网站、物联网、传感器等,这些庞大的数据不容易处理和处理。spark提供对这些数据的实时处理。Spark在Python和SQL语言中具有速度快且易于使用的特点,因此大多数机器学习工程师和数据科学家更喜欢Spark</李>

;

- Spark编程可以用Java、Python、Scala和R来完成,大多数专业人士或大学生都有相关知识。先验知识有助于学习者用他们的已知语言创建spark应用程序。此外,spark开发的scala由java支持。此外,用java为单个应用程序编写的100-200行代码可以转换为

;

- Spark professional在当今的市场上有很高的需求,招聘人员准备通过向Spark开发者提供高薪来改变一些规则。由于Apache spark专业人士的需求量很大,但供应量却很低,因此现在是进入这项技术以赚取高额利润的正确时机</李>

Spark的应用

Apache spark生态系统被业界用来构建和运行快速大数据应用程序,以下是sparks的一些应用程序:

- 在电子商务行业:

分析产品、客户和店内销售的实时交易。这些信息可以传递给不同的机器学习算法,以建立推荐模型。该推荐模型可以根据客户评论和产品评论开发,行业可以形成新趋势。

- 游戏行业:

作为一个spark过程,实时数据程序员可以在一分钟内部署模型,以构建最佳的游戏体验。分析玩家及其行为,创造广告和优惠。此外,spark还可以用于构建实时手机游戏分析。

- 金融服务业:

Apache spark analysis可通过分析大量存档日志来检测欺诈和安全威胁,并将其与用户帐户和内部信息等外部来源相结合,spark stack可帮助我们从这些数据中获得一流的结果,以降低我们财务组合中的风险

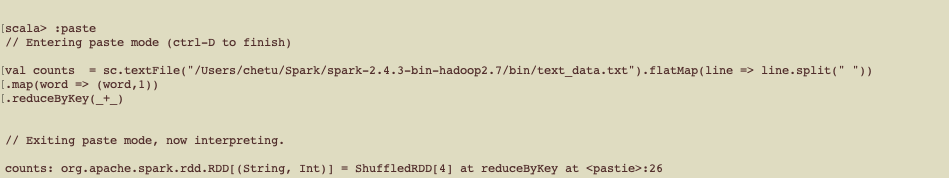

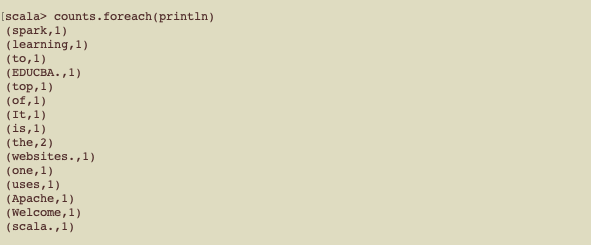

示例(字数示例):

在本例中,我们计算文本文件中的字数:

输出:

先决条件

为了学习ApacheSpark,程序员需要具备Scala函数式编程、Hadoop框架、Unix Shell脚本、RDBMS数据库概念和Linux操作系统的先验知识。除此之外,对Java的了解也是有用的。如果想使用ApachePySpark,那么最好了解python。

目标受众

Apache spark教程面向分析和数据工程师领域的专业人士。此外,希望通过学习各自领域的Spark框架(如ETL开发人员、Python开发人员)成为Spark开发人员的专业人士可以使用本教程在大数据领域进行转换。